Un grupo de investigadores del Instituto Tecnológico de Massachussets (MIT) y del MIT-IBM Watson AI Lab han desarrollado un modelo de aprendizaje automático capaz de capturar cómo se propagará cualquier sonido en una habitación a través del espacio, para ayudar a las máquinas a visualizar mejor los entornos.

Al modelar con precisión la acústica de una escena, el sistema puede aprender la geometría 3D subyacente de una habitación a partir de grabaciones de sonido. Los investigadores pueden usar la información acústica que captura su sistema para crear representaciones visuales precisas de una habitación, de manera similar a como los humanos usan el sonido cuando estiman las propiedades de su entorno físico.

Además de sus aplicaciones potenciales en realidad virtual y aumentada, esta técnica podría ayudar a los agentes de inteligencia artificial a desarrollar una mejor comprensión del mundo que les rodea, como modelar las propiedades acústicas del sonido en su entorno.

En la investigación de la visión por computadora, se ha utilizado un tipo de modelo de aprendizaje automático llamado modelo de representación neuronal implícita para generar reconstrucciones suaves y continuas de escenas 3D a partir de imágenes. Estos modelos utilizan redes neuronales, que contienen capas de nodos interconectados, que procesan los datos para completar una tarea.

Incorporación de propiedades acústicas del sonido

Los investigadores del MIT emplearon el mismo tipo de modelo para capturar cómo el sonido viaja continuamente a través de una escena. Pero descubrieron que los modelos de visión se benefician de una propiedad conocida como consistencia fotométrica que no se aplica al sonido. Si uno mira el mismo objeto desde dos lugares diferentes, el objeto se ve más o menos igual, pero con el sonido, cambian las ubicaciones y el sonido que uno escucha puede ser completamente diferente debido a los obstáculos, la distancia, etc.

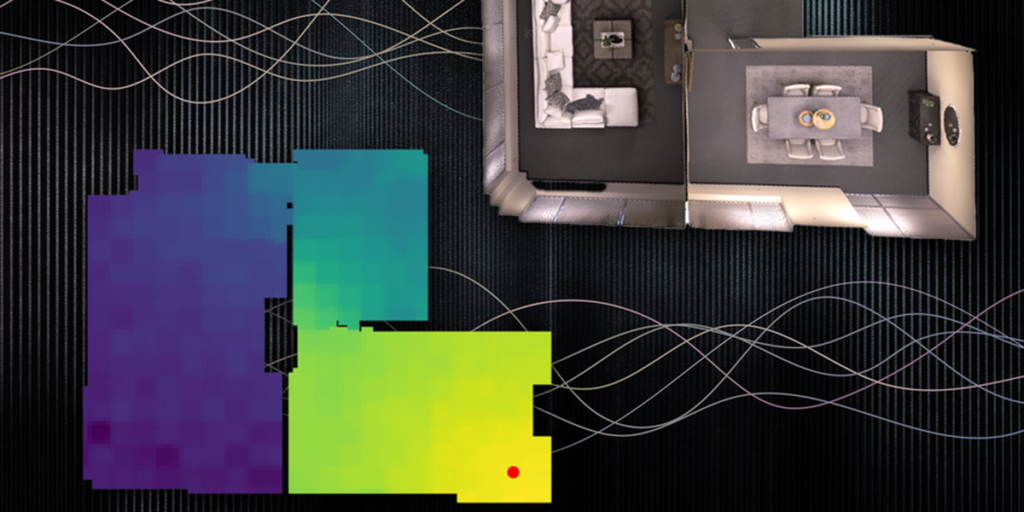

Los investigadores superaron este problema incorporando dos propiedades de la acústica en su modelo: la naturaleza recíproca del sonido y la influencia de las características geométricas locales. Para incorporar estos dos factores en su modelo, llamado campo acústico neuronal (NAF), aumentan la red neuronal con una cuadrícula que captura objetos y características arquitectónicas en la escena, como puertas o paredes. El modelo muestrea aleatoriamente puntos en esa cuadrícula para aprender las características en ubicaciones específicas.

Los investigadores pueden alimentar al NAF con información visual sobre una escena y algunos espectrogramas que muestran cómo sonaría una pieza de audio cuando el emisor y el oyente están situados en ubicaciones de destino alrededor de la habitación. Luego, el modelo predice cómo sonaría ese audio si el oyente se mueve a cualquier punto de la escena.

El NAF emite una respuesta de impulso, que captura cómo debe cambiar un sonido a medida que se propaga a través de la escena. Después, los investigadores aplican esta respuesta de impulso a diferentes sonidos para escuchar cómo deberían cambiar esos sonidos cuando una persona camina por una habitación. Además, descubrieron que aplicar la información acústica que aprende su modelo a un modelo de visión por computadora puede conducir a una mejor reconstrucción visual de la escena.